Вступ

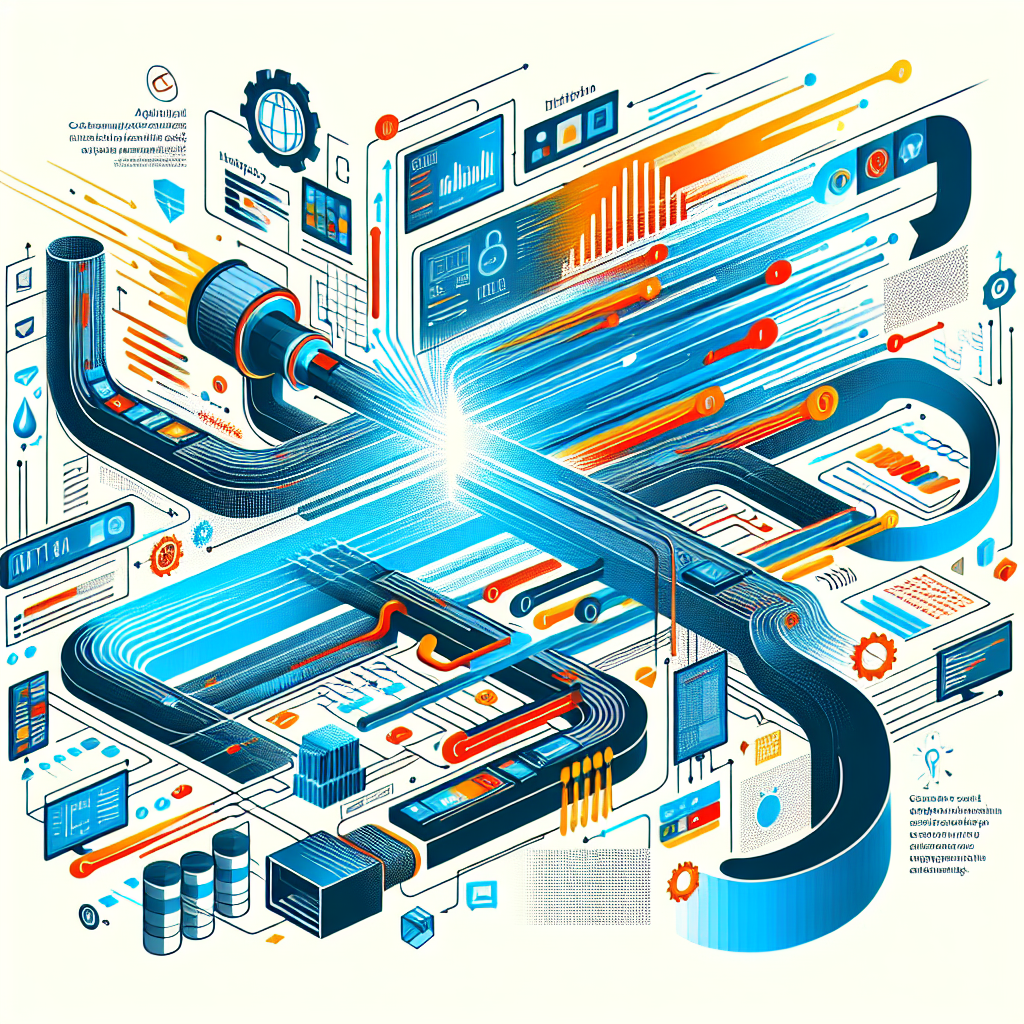

Інженерія даних є основою будь-якої аналітичної платформи. Вона забезпечує плавний потік даних від джерел до корисних аналітичних висновків. Однак створення та підтримка таких платформ потребує впровадження перевірених патернів, що допомагають вирішувати типові задачі - масштабованість, якість даних та простоту супроводу. У цій статті ми розглянемо ключові патерни інженерії даних для аналітичних платформ.

1. Патерни збору даних

Збір даних - перший крок у будь-якому аналітичному конвеєрі. Вибір підходу залежить від швидкості, обсягу та різноманітності джерел даних.

- Пакетний збір (Batch): Підходить для періодичного завантаження великих обсягів даних з баз, файлів або API. Простий у реалізації і надійний для великих даних.

- Потоковий збір (Stream): Обробляє дані в реальному або близькому до реального часі. Інструменти як Apache Kafka чи AWS Kinesis допомагають постійно отримувати дані для термінової аналітики.

- Захоплення змін (CDC): Інкрементально фіксує зміни в базах даних, зменшуючи навантаження і затримки.

2. Патерни зберігання даних

Ефективне зберігання - ключ до продуктивності та масштабованості.

- Data Lake (Озеро даних): Зберігає сирі, неструктуровані або напівструктуровані дані у великому обсязі. Забезпечує гнучкість, але потребує каталогізації та управління.

- Data Warehouse (Сховище даних): Структуроване сховище, оптимізоване для швидких запитів та аналітики. Зазвичай використовується після трансформації даних.

- Lambda Архітектура: Поєднує пакетну і потокову обробку для балансу між затримками та пропускною здатністю.

3. Патерни обробки даних

Перетворення сирих даних у корисні формати - основне завдання.

- ETL (Extract, Transform, Load): Традиційний підхід, коли дані спочатку очищають і трансформують, а потім завантажують у сховище.

- ELT (Extract, Load, Transform): Спочатку завантажує сирі дані, а трансформації відбуваються всередині сховища або lakehouse, використовуючи сучасні обчислювальні можливості.

- Потокова обробка (Stream Processing): Застосовує трансформації в момент надходження даних, за допомогою Apache Flink або Spark Streaming.

4. Патерни якості та валідації даних

Підтримка якості даних потребує постійної уваги.

- Застосування схем (Schema Enforcement): Визначення чітких схем і валідація вхідних даних за ними.

- Профілювання даних: Регулярний аналіз характеристик даних для виявлення аномалій.

- Тестування даних: Написання тестів для конвеєрів для виявлення помилок на ранніх етапах.

5. Патерни оркестрації та моніторингу

Автоматизація і контроль забезпечують стабільність конвеєрів.

- Оркестрація робочих процесів: Використання Apache Airflow, Prefect або подібних інструментів для керування залежностями і планування.

- Сповіщення та логування: Впровадження систем логів і оповіщень про збої або проблеми з продуктивністю.

6. Патерни масштабованості та продуктивності

Підготовка платформи до зростання і швидкої відповіді.

- Розбиття (Partitioning) і шардинг: Ділення даних на частини для розподіленої обробки.

- Кешування: Зменшення часу відповіді за рахунок кешування часто використовуваних даних.

- Автоматичне масштабування ресурсів: Динамічне коригування обчислювальних потужностей під навантаження.

Висновок

Впровадження цих патернів інженерії даних допомагає будувати надійні та масштабовані аналітичні платформи. Вони підвищують якість даних, полегшують супровід і пришвидшують отримання аналітичних висновків. Незалежно від того, чи створюєте ви нову систему, чи оптимізуєте вже існуючу, ці патерни стануть у пригоді.

Додаток: Спрощуйте управління особистим бізнесом

Управління зустрічами та контактами може бути таким же ефективним, як і ваші дані. Meetfolio пропонує простий спосіб створити персональну сторінку візитки та календар бронювань. Завітайте на https://meetfolio.app, щоб спростити планування та розвивати професійні зв’язки.

Спрощуйте свій професійний імідж з Meetfolio. Створюйте персональні сторінки-візитки та налаштовуйте календар бронювань легко на https://meetfolio.app.

Alex D.

Tech Enthusiast & Writer